david bahena, PhD

La hipótesis atómica es una de las ideas materialistas que han sobrevivido más de dos mil años. Hoy se sabe que el átomo es divisible pero la existencia de ladrillos básicos como constituyentes del universo visible es real. La mecánica cuántica es la teoría para el entendimiento del átomo y es la base de casi toda la ciencia y tecnología modernas.

La materia conocida del universo está formada por quarks, electrones y campos y, las interacciones conocidas de la naturaleza son: gravitación, electromagnetismo, nuclear débil y nuclear fuerte.

1. Hipótesis atómica

En la antigüedad griega (siglo III a.C.) dominó el pensamiento de Aristóteles quien pensaba que la materia en el universo estaba compuesto de los elementos: tierra, agua, aire y fuego; y que había dos fuerzas: la que hace subir a los cuerpos y la que hace bajarlos.

También creía que la materia era continua y podría dividirse sin límite. Sin embargo, cien años antes, otros pensadores griegos consideraron que la materia era discreta y que todo estaba formado por pequeñas partículas a las que llamaron “átomos”, los cuales, eran los constituyentes básicos que no podrían dividirse más. Sostenían que la realidad está compuesta por dos causas: lo que es (átomos) y lo que no es (vacío). A Leucipo de Mileto, Demócrito de Abdera y Epicuro de Samos se les atribuye la fundación del “atomismo”.

En esta idea, los átomos son partículas finitas, indivisibles, de formas variadas y siempre en movimiento; y, el vacío, es imprescindible para que exista el movimiento. La atomística de Demócrito se conoce por Lucrecio Caro quien, en su poema “Rerum Natura” (“De la naturaleza de las cosas”), escribió en el siglo I acerca de la estructura del átomo y del vacío, del agrupamiento y movimiento de los átomos. “Nada nace de la nada, nada vuelve a la nada”, expresó, definiendo al cosmos como el conjunto de átomos que se mueven en el vacío.

Pero la atomística no fue considerada ampliamente. Siguieron mil quinientos años de dominio aristotélico. Fue hasta el siglo XVI, con la revolución copernicana, que Giordano Bruno difundió la ideas del heliocentrismo, la pluralidad de mundos y sistemas solares, la infinitud del espacio y el universo, así como, en el movimiento de los átomos.

El universo de Bruno es concebido como un organismo y los átomos son orgánicos y vivientes. En 1704 destacan los descubrimientos de Isaac Newton sobre la naturaleza de la luz, quién demostró que la luz blanca al atravesar un prisma se descompone en varios colores y propuso una teoría corpuscular de la luz, según la cual, está formada por partículas y se propaga en línea recta, no por medio de ondas.

Luego, en 1803, John Dalton estableció un “nuevo sistema de filosofía química”, según el cual la materia es discontinua y está formada por átomos y, el agrupamiento de éstos, forma moléculas.

Después siguieron diversas investigaciones sobre la electricidad y el magnetismo. André-Marie Ampère determinó en 1826 que un campo eléctrico que varía con el tiempo, produce un campo magnético, y la circulación en este campo es igual a la densidad de corriente.

Michael Faraday estableció en 1832 que existen cargas eléctricas con una magnitud definida asociada a los átomos y propuso la existencia de un “cuanto” eléctrico. También, que la inducción electromagnética origina una fuerza electromotriz en un campo magnético.

La teoría dinámica del campo electromagnético fue propuesta en 1864 por James Clerk Maxwell y otros. A partir de las leyes de Gauss, Faraday y Ampére, las ecuaciones de Maxwell describen las propiedades electromagnéticas macroscópicas de la materia. La luz es descrita como una onda electromagnética.

En 1869, Dimitri Mendeleiev clasificó a los elementos químicos según su masa, ordenándolos de acuerdo a sus propiedades y dejando huecos que postulaban la existencia de elementos desconocidos a ese momento.

Diez años después se descubrió la inestabilidad atómica. En 1896, Wilhem Roentgen descubrió un tipo de rayos capaces de atravesar los cuerpos opacos y de impresionar las películas fotográficas. En su momento no se conocía la naturaleza de estos rayos desconocidos y se les llamó X. Hoy se sabe que son una radiación electromagnética de longitud de onda muy corta que se originan en las capas atómicas externas debido a la transición de los electrones de niveles superiores a inferiores de energía.

Al siguiente año, en 1896, Antoine Becquerel descubrió accidentalmente a la radiatividad al encontrar veladas unas placas fotográficas colocadas sobre un mineral de uranio. Marie Slodowska y Pierre Curie estudiaron el fenómeno y concluyeron que era una propiedad característica de ciertos átomos. Las radiaciones fueron identificadas como “alfa”, “beta” y “gamma”, las dos primeras de carácter corpuscular y, la tercera, electromagnética.

La radiatividad es propia de átomos con núcleos inestables desde los cuales se emiten las radiaciones. Estas tienen diversas aplicaciones pero al interaccionar con el tejido vivo pueden causar un “detrimento” a la salud y producir diversos efectos biológicos dañinos, tanto somáticos como genéticos.

En 1897, al realizar experimentos con rayos catódicos se observaron corrientes eléctricas en los tubos de vacío. Joseph John Thompson descubrió al electrón, nombre sugerido en 1974 por Johnstone Stoney, al concluir que los rayos catódicos están formados de pequeños corpúsculos provenientes de los átomos del cátodo que eran desviados por un campo magnético. Calculó entonces la relación de la masa a la carga del electrón. La existencia de éste implicaba que el átomo es divisible.

En el siglo XIX, Pierre Simon Laplace había argumentado en favor del determinismo científico, de manera que, debían existir un conjunto de leyes que nos permitirían predecir todo lo que sucediera en el universo si conociéramos el estado de éste en un instante de tiempo dado. La idea fue abandonada a principios del siglo XX cuando se produjo la llamada “catástrofe ultravioleta”.

Esta, de acuerdo a la física clásica, implicaba que la energía radiada total por un cuerpo caliente podría ser infinita. Para evitar ese resultado, Max Planck propuso en 1900 que la luz, los rayos X y otros tipos de ondas no se emiten en cantidades arbitrarias sino en ciertos paquetes llamados “cuantos”. Con ello se iniciaba el desarrollo de la física cuántica.

2. Teoría cuántica del átomo

2.1 Cuantización de la energía

La teoría cuántica empieza con la “cuantización de la energía”. A la radiación emitida por un cuerpo como resultado de su temperatura se le llama radiación térmica. Hay una clase de cuerpos calientes, llamados cuerpos negros, que emiten radiación térmica con el mismo espectro a una temperatura dada. Tales cuerpos absorben toda la radiación que reciben y, como no reflejan la luz, se ven negros.

A principios de 1900, John Strutt Rayleigh y James Jeans presentaron un cálculo para la densidad de energía de un cuerpo negro. La formulación predecía una producción de energía que tendía al infinito mientras que, los experimentos demostraban que a frecuencias muy altas (región ultravioleta) la densidad de energía tiende a cero. A esto se le llamó “catástrofe ultravioleta”.

La física clásica no podía explicar la situación. Entonces, se produjo una crisis y, a la vez, una revolución en la física. En 1900, Max Planck dedujo un resultado teórico que concuerda con los experimentos y propuso que la energía era una variable discreta, es decir, que solamente podía tomar valores discretos y no arbitrarios. Esto es, la energía se emite en forma de pequeñas cantidades llamadas “cuantos”, caracterizada por dos cantidades, la frecuencia y la llamada constante de Planck (h). Al ser cuantizada la energía empezó la teoría cuántica.

En 1905, Albert Einstein publicó tres importantes artículos. En el primero de estos se refirió al “movimiento browniano•”. Este es un movimiento aleatorio que se observa en algunas partículas microscópicas inmersas en un fluido, por ejemplo, polen en agua. El movimiento aleatorio de las partículas se debe a que su superficie es bombardeada por las moléculas del fluido sometido a agitación térmica. Así, de una manera indirecta, Einstein confirmaba la existencia de átomos y moléculas.

Luego, propuso la cuantificación de la energía electromagnética. Einstein demostró que las partículas cargadas, conocidas como electrones, absorbían y emitían energía en cuantos finitos proporcionales a la frecuencia de la luz o radiación. Esto implicaba a la naturaleza corpuscular de la radiación. La luz es una partícula llamada “fotón”, sin masa, que viaja en el vacío a una velocidad de c=300 mil kilómetros por segundo. A la expulsión de electrones de una superficie mediante la acción de la radiación electromagnética se le llama “efecto fotoeléctrico”.

De acuerdo a esta nueva teoría de la luz, la energía de un fotón es igual a la frecuencia de la radiación multiplicada por la constante de Planck. De esta manera, la energía está distribuida en el espacio de una forma discontinua.

El mismo año, en el contexto de la teoría especial de la relatividad, Einstein propuso el principio la equivalencia entre masa (m) y energía (E) expresada en su famosa fórmula E=mc2, donde c es la velocidad de la luz. Esto implica que la masa con lleva cierta energía aunque el objeto se encuentre en reposo. La masa y la energía son propiedades de la materia en movimiento y las interacciones tienen como límite a la velocidad de la luz.

La relación de Einstein tendría fuertes implicaciones pues en el interior del átomo estaría concentrada una gran cantidad de energía que al liberarse podría utilizarse con diversos fines, incluidos los bélicos, como ha ocurrido. El proceso de producir masa a partir de energía también es posible.

2.2. Cuantización del átomo

A partir del descubrimiento del electrón se idearon muchos experimentos para explorar el interior del átomo. Se conoció la carga del electrón y se encontró que su masa era muy inferior a la de los átomos más ligeros.

Experimentos como el efecto fotoeléctrico y la dispersión de rayos X demostraron que el átomo contenía electrones y que el número de éstos era aproximadamente la mitad del peso atómico del átomo.

Se concluyó que un átomo es eléctricamente neutro y que tenía una carga positiva igual a la negativa de los electrones y que la mayor parte de la masa estaba asociada a la carga positiva.

En 1906, Joseph John Thompson propuso un modelo de átomo como una esfera de carga positiva, en la cual, los electrones se consideraban como cargas puntuales inmersos en la esfera. Este modelo de “pudín de pasas” fue descartado cuando se encontró que no concordaba con el experimento de dispersión de partículas alfa.

Robert Millikan realizó en 1909 el “experimento de la gota de aceite” para determinar la carga del electrón. En 1911, Ernest Rutherford utilizó las partículas alfa para examinar la estructura de la materia. Algunas partículas atravesaban al átomo desviándose con ángulos diversos pero, otras, retrocedían 180 grados.

Esto llevó a Rurherford a suponer que toda la carga positiva del átomo, cuyo tamaño es del orden de un Angstrom (10-8 cm), estaba concentrada en una región pequeña llamada núcleo, del tamaño del orden de un Fermi (10-13 cm), y que los electrones giraban alrededor de éste a la manera de un sistema planetario. Al núcleo del átomo de hidrógeno se le llamó protón.

La conclusión fue muy relevante porque se demostraba que el átomo, considerado indivisible, tenía una estructura interna. Pero una configuración como la de Rutherford implicaba problemas de estabilidad del átomo. De acuerdo con la teoría de Maxwell, las partículas cargadas al ser aceleradas radian ondas electromagnéticas. Entonces, los electrones perderían energía y colapsarían en el núcleo en trayectorias espirales, cuestión que no observamos en la realidad.

En 1913, Niels Bohr presentó una teoría que preservaba la estabilidad del átomo.

Primero, postuló que los átomos existen en “estados estacionarios”, en los cuales no radian energía y son estables. Este postulado es equivalente a la cuantificación de la energía de los átomos. Segundo, el átomo emite o absorbe energía radiante únicamente cuando va de un estado estacionario a otro, y el cambio de energía del átomo es igual a la energía del fotón de radiación que se emite o absorbe. Este postulado invoca el concepto cuántico de la radiación de Einstein.

Finalmente, Bohr propuso una regla de cuantización para determinar los estados estacionarios de energía del átomo. Esta regla se llama •”Principio de correspondencia” y quiere decir que la teoría cuántica tiene un límite clásico, es decir, da los mismos resultados en el límite en que la teoría se conoce como correcta. Con estas bases, los postulados de Bohr permitieron deducir una formulación teórica para las energías permitidas del átomo de hidrógeno, el más sencillo, es decir, un átomo con un solo electrón. Después, calculó los radios orbitales permitidos y encontró que el movimiento orbital angular del electrón está cuantizado, es decir, toma únicamente valores enteros múltiplos de la constante de Planck.

Posteriormente, el concepto atómico de Bohr se abandonó porque, de acuerdo a la mecánica cuántica, las órbitas no pueden definirse. Sin embargo, el éxito de Bohr motivó en 1916 a William Wilson y a Arnold Sommerfeld a estudiar átomos más complejos y a elaborar una teoría más detallada para el átomo de hidrógeno considerando órbitas elípticas tridimensionales y efectos relativistas para el movimiento del electrón. Sin embargo, no fue posible explicar al átomo de helio. Era evidente que hacía falta reformular y generalizar las leyes de la física. Esto ocurrió hacia fines de los años 20’s cuando Erwin Schrodinger y Werner Heisenberg formularon la teoría de la mecánica cuántica.

Poco antes, en 1916, Einstein ajustó la función de Planck asignando probabilidades a los procesos de absorción y emisión de radiación. Si solamente se considera absorción y emisión espontánea se obtiene la ley de Wilhem Wien pero, si se adiciona la emisión estimulada, se obtiene la ley de Planck. Esto sirvió para establecer los fundamentos para el desarrollo de los láseres y de sus predecesores, los máseres (que emiten microondas), utilizando la ley de radiación de Planck basada en los conceptos de emisión espontánea e inducida de la radiación.

Después, en 1923, mediante experimentos de dispersión de electrones por rayos X, Arthur Compton corroboró la teoría corpuscular de la radiación propuesta por Einstein. La teoría cuántica parecía clara pero era necesaria una teoría ondulatoria de la radiación para entender lo fenómenos de interferencia y de refracción.

2.3 Dualidad onda-partícula

En 1924, Louis de Broglie expuso su teoría acerca de las ondas de materia. De acuerdo a esta hipótesis, el comportamiento dual de la radiación, como ondas y partículas, se aplicaba igualmente a la materia. Es decir, la longitud de onda de una onda material está asociada con la cantidad de movimiento de la materia. Con esta base, en el átomo solamente están permitidas aquellas órbitas que contienen un número entero de ondas de De Broglie.

Los experimentos realizados demostraron que la materia se comporta de acuerdo con las leyes del movimiento ondulatorio. A la función que representa la onda de De Broglie se le llama “función de onda”, la cual no mide la trayectoria del movimiento sino las densidades de probabilidad.

La posición exacta de una partícula no se puede especificar en un instante dado sino que se le define mediante la probabilidad de encontrarla en un cierto intervalo de espacio en un instante dado. Así como se suman las funciones de onda para dos ondas electromagnéticas, también se puede hacer para dos ondas de materia superpuestas.

Es decir, a la materia como ala radiación, se aplica el “principio de superposición”. Al siguiente año, 1925, Wolfang Pauli formuló el “principio de exclusión” para explicar la Tabla Periódica de los elementos mediante el modelo de Bohr. Este principio establece que dos partículas materiales idénticas no pueden estar en el mismo estado cuántico, es decir, no pueden tener ambas la misma posición y la misma velocidad dentro de los límites fijados por el principio de incertidumbre.

En el caso de los electrones, el principio de Pauli implica que no pueden ocupar el mismo estado cuántico y tienen que ocupar sucesivas capas electrónicas. Este principio permite explicar porqué las partículas materiales no colapsan en un estado de alta densidad y, sin este principio, sería muy difícil imaginar la estructura de la naturaleza.

El mismo año, Werner Heisenberg, Max Born y Pascual Jordan introdujeron una formulación matricial de la mecánica cuántica para utilizar solamente conceptos observables de energía y probabilidad. Mediante esta mecánica matricial es posible obtener información a partir de conocer el estado inicial y final de un sistema sin tener en cuenta los estados intermedios.

Esto tenía muchas implicaciones acerca del determinismo. De acuerdo al “principio de incertidumbre” de Heisenberg, propuesto en 1926, no se puede determinar simultáneamente y con precisión arbitraria, ciertos pares de variables físicas, por ejemplo, la posición y al cantidad de movimiento, o la energía y el tiempo, de un objeto dado. Heisenberg demostró que la incertidumbre en la posición de la partícula, multiplicada por la incertidumbre en su velocidad y por la masa de la partícula, nunca puede ser más pequeña que la constante de Planck. El principio de incertidumbre es una propiedad fundamental de la naturaleza y tiene profundas implicaciones.

Este principio terminó con el determinismo. Es decir, no se pueden predecir los acontecimientos futuros con exactitud ni siquiera el estado presente del universo. El principio se basa en un conocimiento basado en probabilidades. Las mediciones físicas comprenden la interacción entre el observador y el sistema observado y el principio de incertidumbre es una consecuencia de la dualidad onda-partícula.

En 1926, Erwin Schrödinger fundó la mecánica ondulatoria introduciendo una equivalencia parcial con la mecánica matricial. Junto con Werner Heisenberg y Paul Dirac se reformuló a la teoría de la mecánica cuántica, basada en el principio de incertidumbre.

En esta teoría, las partículas no poseen posiciones y velocidades definidas separadamente, pues éstas no podrían ser observadas. Ahora, las partículas tienen un estado cuántico que es una combinación de posición y velocidad.

En general, la mecánica cuántica no produce un resultado único de cada observación, sino cierto número de resultados posibles, dando la probabilidad de cada uno de ellos. Un sistema físico queda descrito por una función de onda que proporciona información sobre la distribución de probabilidades. De acuerdo a la hipótesis de Planck, la luz formada por ondas se comporta en algunos aspectos como si estuviera formada de partículas que solo pueden ser emitidas o absorbidas en paquetes o cuantos.

De acuerdo al principio de Heisenberg, las partículas se comportan en algunos aspectos como ondas, es decir, no tienen una posición bien definida sino que están esparcidas en una cierta distribución de probabilidad. Esto es, en mecánica cuántica existe una dualidad onda-partícula. Una consecuencia se puede observar en el fenómeno de interferencia de ondas o de partículas. Si una fuente de luz se proyecta sobre una placa con dos rendijas, una pequeña cantidad atravesará a éstas. Si del otro lado de la fuente luminosa se coloca una pantalla se observa un diagrama de franjas luminosas y oscuras.

Esto ocurre porque las ondas que pasan por las rendijas no están en fase cuando llegan a la pantalla, de manera que, algunas se reforzarán y otras se cancelarán. Algo similar ocurre si, en vez de luz, se utilizan partículas como electrones en cuyo caso se produce un patrón de interferencia. En 1927, George Paget Thompson demostró que los haces de electrones se difractan al pasar a través de películas delgadas. Pero, bajo las condiciones de la óptica física, no solamente los electrones sino todos los objetos materiales, cargados eléctricamente o no, muestran características ondulatorias en su movimiento.

Ese año, Bohr formuló la llamada “interpretación de Copenhague” conocida como “principio de complementariedad”, según la cual, ambas descripciones, la ondulatoria y la corpuscular son necesarias para comprender al mundo cuántico.

2.4 Cuantización del núcleo atómico

Con base en el formalismo cuántico, en 1928, George Gamow estudió la radiatividad alfa. Supuso que estas partículas están encerradas en el núcleo atómico en un pozo de potencial del cual, según la mecánica clásica, nunca podrían salir por no tener suficiente energía pero, de acuerdo a la mecánica cuántica, tienen una cierta probabilidad de hacerlo mediante el llamado “efecto túnel”.

De acuerdo al principio de incertidumbre, Gamow supuso que una pequeña parte del núcleo atómico de la partícula alfa no está exactamente en el centro del núcleo sino ligeramente separada, de manera que, predomina la fuerza de repulsión electrostática y no la interacción nuclear fuerte. Así, el efecto túnel explica el proceso de emisión de partículas alfa del núcleo atómico. El efecto también explica los procesos para la producción de energía en las estrellas, es decir, las reacciones de fusión termonuclear, en las cuales, los átomos ligeros se aproximan suficientemente para fusionarse luego de haber superado sus barreras de potencial mediante el efecto túnel.

En 1928, Paul Dirac formuló una teoría relativista del electrón, consistente con la mecánica cuántica y la teoría especial de la relatividad, es decir, una teoría electrodinámica cuántica. Con su ecuación de onda, Dirac predijo la existencia del antielectrón o positrón, en cuya aniquilación la masa se transforma en energía. Por algún tiempo se había especulado acerca de la existencia de otras partículas (sin carga), adicionales al protón, debido a que las masas de los átomos de número atómico superior al hidrógeno resultaban ser superiores a la suma de las masas de sus protones. La nueva partícula, el neutrón, fue descubierta por James Chadwick en 1932.

Con ello se descubrió que el núcleo atómico tiene estructura interna y está formado por protones y neutrones. Ambos se mantienen unidos en el interior del núcleo debido a una fuerza llamada nuclear fuerte. El mismo año Heisenberg propuso un modelo de núcleo formado con protones y neutrones ligados por el intercambio de electrones.

Ese año, también, al estudiar los rayos cósmicos Carl David Anderson descubrió al positrón constituido por una carga eléctrica positiva. El positrón es la antipartícula del electrón y correspondía a la partícula predicha por Dirac. La interacción de un electrón y un positrón resulta en la aniquilación de ambos y la creación de dos fotones gamma cuya energía equivale a la masa del par electrón-positrón.

El fenómeno inverso, la creación de pares, también es posible. Este descubrimiento fue la primera evidencia de existencia de antimateria. De hecho, al principio de la expansión del universo existía casi la misma cantidad de materia y antimateria.

Desde fracciones de segundo después del Big Bang existe antisimetría. En 1933, Enrico Fermi propuso una teoría de la radiatividad beta basada en la teoría cuántica de campos de Dirac, Heisenberg y Pauli. En este proceso, un núcleo atómico inestable emite una partícula beta, que puede ser un electrón o un positrón. La desintegración beta se debe a la interacción nuclear débil que transforma a un neutrón en un protón, o viceversa, creando un electrón o un positrón, respectivamente.

En otro proceso en competencia, un neutrón puede capturar a un electrón para producir un protón y un neutrino. Para evitar la violación de la conservación de energía Pauli propuso la existencia del “neutrino” (y antineutrino), partícula (o antipartícula) sin carga y aparentemente sin masa no detectada a ese momento. Se creía que los protones y neutrones eran partículas elementales pero, para que la interacción fuerte los mantuviera unidos en el núcleo era necesaria la existencia de partículas mensajeras.

En 1935, Hideki Yukawa introdujo una nueva teoría según la cual el protón y el neutrón se atraen mutuamente intercambiando una partícula virtual de masa intermedia entre las partículas nucleares y los electrones, es decir, un mesón. Considerando la interacción a distancia a través del intercambio de partículas, Yukawa introdujo el concepto de “campo” para describir el comportamiento de magnitudes que se definen en todo punto de una región del espacio-tiempo. En 1937, Anderson y colaboradores corroboraron la teoría de Yukawa al descubrir en los rayos cósmicos a una partícula inestable doscientos veces más pesada que el electrón a la que se llama muón, tanto de carga positiva como negativa. Este, sin embargo, no era el mesón de Yukawa sino un elemento de su decaimiento.

En 1939, habiéndose descubierto el neutrón, Fermi produjo en Chicago la primera reacción de fisión en cadena. Otro tanto hizo Otto Hahn en Alemania. La fisión significa el rompimiento de un núcleo atómico pesado, como el uranio, cuando es bombardeado por neutrones.

Una secuencia de estas reacciones produce una reacción de fisión nuclear en cadena. Con esas ideas, los científicos nucleares se fueron a la guerra intentando la manufactura de una bomba en Alemania o incorporándose de lleno al proyecto Manhattan en los Estados Unidos. Muchos coincidían en que Alemania pretendía construir la bomba. Entonces, para disuadir a Hitler sugirieron “ingenuamente” al gobierno de Estados Unidos que intensificara la investigación nuclear. Eso fue, precisamente, lo que ocurrió.

Los grandes científicos de la época terminaron colaborando con un proyecto de muerte que algunos celebraron en la ebriedad como un triunfo cuando estalló la explosión en Nagasaki.

Como consecuencia de la equivalencia de masa y energía de Einstein, en el proceso se libera una gran cantidad de energía que puede utilizarse con fines pacíficos o militares. En 1945, Hiroshima y Nagasaki fueron el blanco de las experiencias bélicas previas realizadas en Nevada y Los Alamos, en los Estados Unidos. Miles de japoneses murieron dejando secuelas de los daños biológicos hasta el día de hoy. En la posguerra, varios científicos nucleares adscritos al proyecto Manhattan recibieron el premio “Atomos para la paz”.

3. Partículas elementales

3.1 Cuantización de las partículas

En 1947, Cecil Frank Powell y colaboradores descubrieron al mesón Pi () o pion. De acuerdo a la teoría de Yukawa, la fuerza nuclear fuerte se debe al intercambio de piones. Eso funcionaría bien para el intercambio entre un protón y un neutrón pero no entre dos neutrones o dos protones.

En este caso, se requería un mesón neutro que pronto fue encontrado, estableciéndose la existencia de los piones positivo (+), negativo (-) y neutro (0).

Hacia ese año parecía que se había logrado entender la estructura del átomo. Fotones, electrones, positrones, protones, neutrones y piones habían sido descubiertos y se tenía la certeza de la existencia del neutrino. Todo parecía elemental y explicable excepto el muón. Eso motivó el desarrollo de la física de las altas energías utilizando aceleradores de partículas, como el cosmotrón o el bevatrón, en Estados Unidos.

Las actividades, sin embargo, estaban centradas en producir isótopos radiativos con fines médicos. Antes de la guerra, Heisenberg y Pauli se habían comprometido a elaborar una teoría general de las partículas que no fue presentada por el inicio de la guerra.

Después de ésta, entre 1947-50, Shin’ichiro Tomonaga, Julian Sshwinger y Richard Feynman formularon la electrodinámica cuántica (QED) nueva, que es la teoría cuántica del campo electromagnético, misma que logró un rápido desarrollo teórico.

En 1948 habían comenzado a aparecer multitud de partículas llamadas “extrañas” (mesones pesados, hiperones) por ser desconocidas y los aceleradores de partículas aumentan sus energías permitiendo numerosos experimentos. En 1953, Murray Gell-Mann introdujo la simetría llamada “extrañeza” para explicar el comportamiento de producción y desintegración de partículas extrañas, así como las simetrías SU(2) y SU(1). En 1961, Murray Gell-Mann, Yuval Ne’eman y David Speiser formularon una simetría interna unitaria llamada SU(3) y, en 1962, Gell-Mann hizo la predicción del barión Omega (-) que se detecta en 1964 confirmando a la simetría SU(3).

Ese año, Gell-Mann propuso el modelo de tres quarks, es decir, tres tipos de subpartículas o “sabores” que combinadas entre sí o con los correspondientes antiquarks, daban cuenta de más de 300 bariones o mesones identificados hasta entonces. Como partículas ligeras, o leptones, se consideraba al electrón al electrón, al muón y sus neutrinos.

Se inició la búsqueda experimental de esos quarks especulando sobre las propiedades que tendrían. En el modelo de tres quarks de Gell-Mann, un barión (protón, neutrón) está constituido por tres quarks, un mesón por un quark y un antiquark. Los tres quarks serían los llamados “up” (arriba), “down” (abajo) y “strange” (extraño) con sus correspondientes antiquarks. Steven Weinberg, Abdus Salam y Sheldon Lee Glashow formularon en 1967 la teoría electrodébil que unifica la electrodinámica cuántica de las interacciones electromagnéticas y la teoría de las interacciones débiles.

En 1971, Gerardus t’Hoofft hizo la corrección a la “renormalización” de Weinberg-Salamn eliminando los infinitos a cualquier grado de aproximación. En 1973, en el Centro Europeo de Investigaciones Nucleares (CERN) de Suiza, se detectaron las corrientes débiles neutras predichas por la teoría electrodébil.

Al año siguiente, fue detectado por Samuel Chao Chung Ting y Burton Ritcher, el cuarto quark predicho por t’Hooft, llamado “encanto” (c). Mas tarde, en 1978, se descubrió el quinto quark, llamado “fondo” (b) y se supuso a un sexto llamado “cima” (t) que sería descubierto en 1995. En 1972, Gell-Mann y Harald Fritzsch introdujeron la Cromodinámica Cuántica (QCD) o teoría del color para explicar el confinamiento de los quarks. Según ésta teoría, cada quark, además de uno de los tres “sabores” (u, d, s) tiene uno de los tres “colores” primarios (por ejemplo, rojo, amarillo y azul) y, por tres colores secundarios (por ejemplo, naranja, verde y violeta) para los correspondientes antiquarks. Pero las partículas libres de la naturaleza son “incoloras”, o sea, obtenida por superposición de los quarks. Sin embargo, estos “colores”, como los “sabores”, no son reales sino solo denominaciones de trabajo.

De esta manera, los bariones (protones, neutrones) están formados por tres quarks de distinto color; dos colores complementarios forman aun mesón, a su vez, formado de un quark y un antiquark. Esto significa que ni los protones ni los neutrones son indivisibles. En 1978, Martin Lewis Perl descubrió una tercera partícula ligera, el leptón Tau () o tauón.

Así, en el congreso de Tokio de ese año se propuso el “modelo estándar de las partículas elementales”, según el cual, el universo está constituido por tres pares de leptones y tres pares de quarks. Los leptones son: el electrón, el muón y el tauón, cada uno con un neutrino asociado, es decir, el neutrino electrónico, el muónico y el tauónico, respectivamente.

Los quarks son: u, d, s, c, b, t. Los leptones y quarks están agrupados en tres familias, la primera de las cuales, son constituyentes del universo ordinario, es decir, quark d, quark u, electrón y neutrino electrónico. La fórmula del protón es “uud” y, al del neutrón es “udd”. Esto es, un protón contiene dos quarks “up” (u) y un quark “down” (d); un neutrón contiene dos quarks “down” y un quark “up”. La combinación con los demás quarks puede crear partículas de masa mucho mayor que decaen rápidamente en protones y neutrones. Este tipo de partículas, quarks y leptones, son distinguibles, cumplen el principio de exclusión de Pauli y se les conoce como “fermiones”, partículas distinguibles que obedecen a la estadística de Fermi-Dirac y cumplen con el principio de exclusión de Pauli. El neutrino es una partícula elemental cuya existencia fue postulada por Pauli en 1930 para explicar la conservación de energía en las reacciones nucleares. Tomó mas de 30 años confirmar la existencia de los neutrinos.

De acuerdo al modelo estándar existen en tres diferentes “sabores” o tipos de neutrinos que no poseen carga eléctrica, probablemente pesan más de cien veces la masa del electrón, oscilan e interactúan de manera extremadamente débil con la materia y están asociados con su correspondiente leptón.

En los objetos astrofísicos los neutrinos se producen cuando ocurren las reacciones nucleares a densidades y temperaturas extremas, por ejemplo, en el Sol, el universo temprano, núcleos estelares o explosiones de supernova. Para todas las partículas se consideran las correspondientes antipartículas.

Así los seis quarks tienen seis antiquarks y, los seis leptones, seis antileptones. En el caso de los neutrinos, la partícula y la antipartícula es la misma.

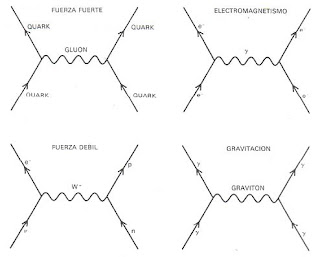

3.2 Fuerzas de la naturaleza

En mecánica cuántica hay interacciones entre las partículas materiales que son transmitidas por partículas portadoras de fuerza o bosones. Estas tienen la propiedad de ser partículas indistinguibles, obedecen la estadística de Bose-Einstein y no cumplen el principio de exclusión de Pauli.

Esto significa que no existe un límite de partículas que se pueden intercambiar, por lo que, pueden dar lugar a fuerzas muy intensas. Pero, si estas partículas poseen gran masa resulta difícil producirlas e intercambiarlas a grandes distancias. Las partículas que intercambian las partículas materiales entre sí se dice que son “virtuales” porque no se pueden detectar.

Pero existen porque tienen un efecto medible, es decir, producen la fuerza entre las partículas materiales. Algunas veces, sin embargo, esas partículas virtuales se pueden detectar en forma de ondas luminosas u ondas gravitatorias. Las partículas portadoras de fuerza se agrupan en cuatro categorías, de acuerdo con la intensidad de la fuerza que transmiten y con el tipo de partículas con que interactúan.

Estas categorías corresponden al tipo de interacción conocida existente en la naturaleza que son: electromagnética, nuclear débil, nuclear fuerte y gravitacional. La fuerza electromagnética interactúa con partículas cargadas eléctricamente, es decir, electrones o quarks.

La fuerza entre cargas iguales es atractiva y, entre cargas opuestas, es repulsiva. Esta fuerza es de largo alcance y se representa por el intercambio de un gran número de partículas virtuales llamadas “fotones”, sin masa, mismos que también pueden observarse como “reales” en diversas circunstancias.

La fuerza nuclear débil es la responsable de la radiatividad y fue comprendida con la teoría electrodébil que unificó con la fuerza electromagnética con la débil. Weinberg y Salam sugirieron que, además del fotón, había otras partículas, conocidas como bosones vectoriales masivos, que transmiten a la fuerza débil. Estos bosones se conocen como W+, W- y Z0, cada uno una masa de 100 giga electron-volts (GeV), los cuales tienen una vida media muy corta y son de muy corto alcance. La fuerza nuclear fuerte mantiene unidos a los quarks en el protón y en el neutrón, y a éstos juntos en los núcleos de los átomos.

Se cree que esta fuerza es transmitida por una partícula llamada “gluón” que solo interactúa consigo misma y con los quarks. La fuerza es, por tanto, muy intensa y de corto alcance. La propiedad llamada “confinamiento” impide que los quarks se puedan observar aisladamente pues siempre liga a las partículas en combinaciones tales que el conjunto total no tiene color.

El confinamiento también impide que se tengan gluones aislados, porque los gluones entre sí también tienen color. Se necesita, entonces, tener una colección de gluones para dar el color blanco. Esta colección forma una partícula inestable llamada “glueball” (bola de gluones). Los conceptos de quark y gluón están bien definidos. A energías normales los gluones unen a los quarks entre sí, a energías elevadas la interacción se hace menos intensa y los quarks y gluones se comportan casi como partículas libres. La fuerza gravitacional es universal porque toda partícula la experimenta de acuerdo a su masa y energía.

Esta fuerza es débil, actúa a grandes distancias y se considera que es atractiva. En este caso, la fuerza transmitida entre dos fuerzas materiales se podría representar por el “gravitón”, partícula que no posee masa propia y es de largo alcance. El efecto es medible, por ejemplo, entre la Tierra y el Sol, las partículas virtuales que se intercambian hacen girar a la primera alrededor del segundo. Los gravitones reales serían las ondas gravitacionales que son débiles, difíciles de detectar y no han sido observadas.

A partir del éxito con la unificación electrodébil, se ha intentado unificar a estas dos fuerzas con la nuclear fuerte en lo que se llama “teorías de gran unificación” (GUT). La idea está basada en que a altas energías, la fuerza nuclear se hace menos intensa mientras que la fuerza electrodébil se hace más intensa. A una determinada energía, llamada de unificación, las tres fuerzas deberían tener la misma intensidad y ser, por tanto, aspectos de una única fuerza.

Además, las GUT predicen que a esta energía los electrones y los quarks serían esencialmente iguales. El valor de la energía de unificación no se conoce muy bien pero tendrían un valor tan grande que hace difícil comprobar la teoría en el laboratorio. Pero existen consecuencias de la teoría que han sido exploradas a baja energía, es el caso del decaimiento del protón o el neutrón sin que se haya producido ninguna evidencia experimental.

Ahora bien, las teorías GUT no incluyen a la gravedad. Esta es importante porque determina la evolución del universo, en algunos casos, domina sobre el resto de las fuerzas y hace que una estrella colapse en agujeros negros.

3.3 Leyes de conservación

En todo proceso en que interaccionan partículas, existen magnitudes o propiedades que se conservan, es decir, que no cambian debido a invariancias del sistema bajo ciertas transformaciones.

Una ley de conservación puede ser válida en todos o alguno de los procesos según el tipo de interacción que intervenga. Se consideran dos tipos de leyes de conservación, las absolutas y las relativas.

Entre las primeras están las leyes de conservación de: energía y momento, momento angular total, carga eléctrica y simetría CPT (que representa la conjugación de la carga C, la inversión espacial P y la temporal T). Entre las relativas, están: paridad, isospin, números bariónico y leptónicos, extrañeza, “encanto”, “belleza” y “verdad”, y conjugación de carga y simetría CP.

La importancia de las leyes de conservación es enorme. Las simetrías facilitan la comprensión de lo que sucede en el mundo cuántico. Las tres simetrías fundamentales están relacionadas con el espacio, el tiempo y la antimateria.

La invariancia de las leyes físicas ente reflexiones se llama “paridad” o simetría P e implica que las leyes son las mismas para una situación cualquiera y para su imagen especular. En 1956, Tsung-Dao Lee y Chen Ning Yang demostraron que en el decaimiento beta del neutrón, producido por las interacciones débiles, no se conserva la paridad P.

Los neutrinos también violan completamente la paridad, lo que permite distinguir un neutrino de un antineutrino. La simetría relacionada con el intercambio de carga eléctrica se llama conjugación de carga o simetría C e implica que las leyes son las mismas para las partículas y las antipartículas.

Es decir, la interacción de la luz con la materia o la antimateria es idéntica. Pero, la simetría C es violada por las interacciones débiles. Lo que si parece que se conserva es una combinación de simetrías C y P. La simetría del tiempo T implica que las leyes de la física son las mismas si el tiempo transcurre del pasado al futuro o al revés.

Pero el tiempo fluye del pasado al futuro, es decir, parece que corre en una sola dirección. En 1994, Shahen Hacyan concluía que la dirección del tiempo es una propiedad “exclusivamente” estadística.

Esto es así porque los cuerpos macroscópicos evolucionan en una sola dirección en el tiempo, “las moléculas y los átomos no distinguen entre pasado y futuro”. Una de las propiedades estadísticas de la naturaleza es la “entropía”, que es una medida del desorden de un sistema. La entropía está directamente relacionada con la dirección del tiempo.

De acuerdo a la segunda ley de la termodinámica, la entropía total de un sistema siempre aumenta con el tiempo. Sin embargo, esta ley estadística solo tiene sentido cuando se aplica a conjuntos muy grandes de moléculas aisladas del resto del universo.

A nivel cuántico no ocurre la asimetría entre pasado y futuro, esto es, los fenómenos cuánticos satisfacen la simetría T. Sin embargo, la dirección del tiempo no está resuelta a nivel microscópico. Así pues, se tienen tres simetrías fundamentales: C, P y T. las dos primeras no son simetrías válidas pero una combinación de ellas sí lo es.

De hecho, se puede demostrar que cualquier fenómeno físico, independientemente de la clase de interacción, debe satisfacer una combinación de simetrías. A nivel cuántico no existe una dirección privilegiada del tiempo pero, el problema del sentido del tiempo, no está resuelto. De acuerdo al teorema CPT cualquier teoría que obedezca a la mecánica cuántica y a la relatividad debe poseer siempre una simetría combinada.

Pero, si se invierte la dirección del tiempo, las leyes de la física tendrían que cambiar pues, a gran escala, el universo en expansión no posee la simetría T. Cuando el tiempo avanza, el universo se expande; si el tiempo retrocediera, el universo se contraería.

Diagramas de Feynman que describen las cuatro interacciones

fundamentales de la naturaleza.

fundamentales de la naturaleza.

4. Cosmología física

4.1 Universo de quarks

A gran escala del universo parece gobernar la teoría de la relatividad general de Einstein. En este caso, no se tiene en cuenta el “principio de incertidumbre” de la mecánica cuántica.

Esto es consistente con las observaciones para campos débiles. Pero, tratándose de campos gravitacionales intensos, como el Big Bang y los agujeros negros, los efectos cuánticos son importantes. Sin embargo, no se tiene una teoría que unifique a la mecánica cuántica con la relatividad. Usando la dualidad onda-partícula, todo el universo, incluyendo la luz y la gravedad pueden ser descritos en términos de partículas.

El universo observable que conocemos actualmente es muy vasto, lleno de estrellas, galaxias y otros objetos. Desde hace cien años se sabe que el universo está en expansión y, recientemente, se considera que también está en aceleración. La materia visible, luminosa, en el universo se considera de apenas el 0.4% del total, siendo la materia bariónica del 3.6%, la mayor parte del universo no se ve, 23% es de materia oscura y 73% de energía oscura sin que, en ambos casos, se conozca su naturaleza.

La materia bariónica está hecha de protones y neutrones, es decir, de quarks. De manera que, el universo observable está formado por quarks. Un caso conocido son las estrellas de quarks, que son parte de las estrellas de neutrones formadas por la explosión de las supernovas a partir de estrellas masivas evolucionadas.

El remanente de la explosión es una nebulosa con una estrella central de neutrones compacta y de alta densidad que emite ondas de radio. La energía que hace brillar a las estrellas ocurre por reacciones de fusión termonuclear a base de átomos de hidrógeno y helio, es decir, electrones y quarks.

En suma, el universo visible está hecho de quarks, electrones y campos, y podría contener más quarks que antiquarks. De hecho, el universo muy temprano estuvo hecho de quarks y electrones, a partir de los cuales se formaron los primeros átomos.

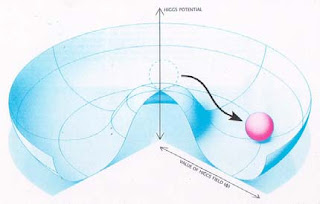

4.2 Vacío y campo de Higgs

La consecuencia más importante de la expansión del universo es su concentración espacial, en el pasado, en un punto con una densidad y temperatura infinitas. Sin embargo, la descripción del universo, desde el punto de vista cuántico, no tiene sentido al tiempo cero.

Al inicio de la expansión, llamado tiempo de Planck, solo había campos de energía que vibraban y esas vibraciones correspondían a partículas.

A ese momento, las cuatro interacciones fundamentales de la naturaleza estaban unificadas en una sola. Pero cuando la temperatura bajó, el universo entró en una fase de “inflación” exponencial liberando enormes cantidades de energía que aceleraría la expansión del universo.

La “inflación” es un campo cuántico que separa las interacciones fuertes de las electrodébiles. A ese momento empezaría a funcionar el llamado mecanismo de Higgs para formar la masa de las partículas.

En los años 70s, para explicar la masa de los bosones W y Z de la teoría electrodébil, Weinberg y Salam recurrieron a la idea de Peter Higgs, según la cual, el espacio estaría lleno de un campo que interactúa con las partículas y genera su masa. En el campo de Higgs la energía es cero pero su intensidad es diferente de cero.

Este es el caso del vacío total donde el valor de energía es el mínimo posible, es decir, cero; pero la intensidad del campo de Higgs en el vacío no es cero. La intensidad también es energía pero el vacío no posee energía, entonces, la energía asociada a la intensidad está en forma de la masa que adquieren las partículas W y Z.

La energía del campo de Higgs depende de la temperatura. Para las interacciones débiles la temperatura crítica es muy elevada, similar a la existente en el universo temprano. Se estima que a la temperatura crítica se produjo un cambio de fase y por debajo de esa temperatura el campo de Higss generó las masas de las partículas.

Como todo campo cuántico, el de Higgs vibra y sus vibraciones son ondas y partículas a la vez. Las vibraciones del campo de Higgs son partículas tipo bosones, mismos que no han sido descubiertos. En el gran acelerador colisionador de hadrones (LHC) del CERN de Suiza está en desarrollo un conjunto de experimentos para detectar al campo de Higgs.

Se considera que un mecanismo como éste podría explicar la masa de todas las partículas. Esto significaría que el espacio estaría lleno de muchos campos de Higgs y el estado de mínima energía, el vacío, tendría una intensidad tal que generaría la masa de todas las partículas.

En la física clásica, el vacío se considera como la ausencia de todo pero, cuánticamente, la situación es diferente. Es espacio está lleno de campos, los cuales vibran y tienen fluctuaciones porque nunca están en reposo absoluto. Esto es congruente con el principio de incertidumbre de Heisenberg el cual impone condiciones inherentes a la naturaleza.

Una partícula no puede estar en reposo absoluto, ya que, implicaría que estuviera presente en todas partes del universo, pues la incertidumbre en su posición sería infinita. Este principio también se aplica a los campos y, a las fluctuaciones cuánticas, que se pueden interpretar como partículas que se crean y destruyen en tiempos muy breves, son indetectables y se les conoce como partículas virtuales que producen efectos reales.

La creación y aniquilación de partículas implican cambios de energía, modulados por el principio de incertidumbre de Heisenberg. Este mar de partículas virtuales tiene la propiedad de que la suma de los términos masa-energía y presión es negativa. Consecuentemente, habría atracción a escalas cortas y una repulsión a escalas largas, si bien, no se sabe como tratar a la energía del vacío en el marco de la teoría de la relatividad general. Pero el vacío cuántico podría tener efectos cosmológicos importantes para explicar la aceleración de la expansión del universo; también podría estar relacionado con la materia oscura. La expansión acelerada del universo se ha observado y podría estar generada por una gravedad repulsiva.

4.3 Materia y energía oscura

En muchos sistemas astrofísicos la masa inferida de las estrellas luminosas no es suficiente para explicar la dinámica del objeto, debe adicionarse materia cuya presencia solamente es revelada por efectos gravitacionales, por ejemplo, en los movimientos orbitales de las galaxias en cúmulos o en la rotación de galaxias espirales.

Por ello, se ha postulado la existencia de una forma de “materia oscura”. De hecho la mayor parte de la masa en el universo consiste de esta materia cuya naturaleza física no se conoce.

Cuando los constituyentes de la materia oscura se mueven a velocidades menores a la de la luz se llama materia oscura fría. Los candidatos para la materia oscura incluyen a un con junto de partículas elementales, aún no descubiertas, llamadas “partículas masivas débilmente interactuantes” (WIMPs).

Entre otras, se han propuesto al neutralino supersimétrico, también a las partículas llamadas “Q-balls” y, el llamado campo escalar “oscilatón”. Asimismo, se piensa que una proporción importante del universo está constituida por “energía oscura”, cuya naturaleza también se desconoce.

Esta energía sería la responsable de la aceleración del universo y, probablemente, pudiera explicarse a partir del vacío cuántico. Epílogo Entre las teorías alternas al Big Bang, desde hace 30 años, se propuso la teoría de cuerdas cósmicas como una teoría matemática de once dimensiones, de las cuales solo podemos percibir cuatro, para explicar a cada partícula elemental como la vibración de una cuerda de tamaño subatómico. Sin embargo, esta teoría no está probada.

En suma, el mundo que conocemos está hecho de campos de materia, cuyos cuantos se llaman fermiones (quarks y electrones), y campos de fuerza (fotones, gluones, etc.) cuyos campos se llaman bosones. Estos campos son los ladrillos que forman al universo observable visible, incluyendo a los seres vivos. La vida es la forma viva de la materia y está hecha de estos ladrillos formando estructuras altamente organizadas cuya dinámica no comprendemos cabalmente.

Referencias Alcubierre M., Siddhartha F., Matos T. et al. 2002, [arXiv: astro-ph/0204307v1]. Caro T.L. 1999, De la Naturaleza de las Cosas, Biblioteca virtual Miguel de Cervantes, en www.cervantesvirtual.com Doncei M.G. 2002, La Revolución Cuántica: Nueva Visión en Física y en Filosofía, en Física Cuántica y Realidad, C. Mataix y A. Rivadula (eds), U. Complutense, p.17. Fernandez-Rañada A. 2002, La Mecánica Cuántica y el Espacio Vacío, en Física Cuántica y Realidad, C. Mataix y A. Rivadula (eds), U. Complutense, p.315. Fernández R., Ramón M. 2003, Partículas Elementales, FCE. Hacyan S. 1994, Del Universo Cuántico al Universo en Expansión, FCE. Hawking S. 1996, Historia del Tiempo, Crítica. Información general, en es.wikipedia.org Mataix C., Rivadulla A. (eds.) 2002, Física Cuántica y Realidad, U. Complutense. Kane G. 1987, Modern Elementary Particle Physics, Addison-Wesley. Resnick R. 1981, Conceptos de Relatividad y Teoría Cuántica, Limusa.